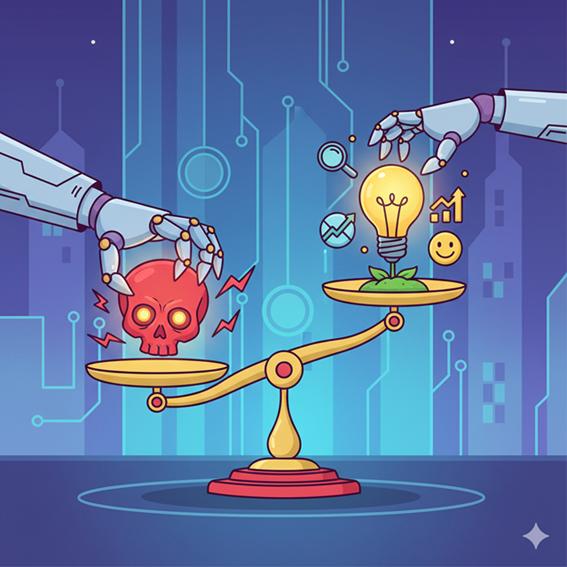

Una risorsa da valutare

Cos’è l’intelligenza artificiale?

L’intelligenza artificiale può essere definita come un sistema basato su reti neurali artificiali che imitano il cervello e il linguaggio umano perché “addestrate” a leggere miliardi di testi. Lo scopo è quello di riconoscere strutture, significati e contesti delle parole, imparare le probabilità con cui una parola segue un’altra fornendo così la risposta più probabile secondo una logica di coerenza.

Quali sono gli aspetti utili e quali potenzialmente dannosi dell’utilizzo dell’intelligenza artificiale nei diversi ambiti?

IA e apprendimento

Uno studio della Stanford University del 2024, ha dimostrato che studenti che si interfacciavano con l’ IA in modo interattivo hanno ottenuto punteggi più elevati a test di comprensione rispetto al gruppo di studio tradizionale. L’IA potrebbe quindi rendere lo studio più efficiente se usata non come scorciatoia e non in sostituzione di un tutor umano. La soluzione più efficace è considerare l’IA un supporto più che un sostituto dell’insegnante o tutor nell’apprendimento. L’IA potrebbe inoltre facilitare l’inclusione aiutando le persone con difficoltà di lettura e scrittura o con disabilità comunicative ad esprimersi più facilmente attraverso l’aiuto nella comprensione e nella produzione scritta e orale.

IA e informazione

In un’analisi condotta dal NewsGuard, società di monitoraggio dell’affidabilità dei siti di notizie e informazioni, è risultato che i dieci principali modelli di IA generativa hanno ripetuto fake news su argomenti di attualità nel 35% dei casi in cui sono stati interpellati: dall’analisi emerge come la percentuale di casi in cui sono state riferite delle informazioni false è quasi raddoppiata rispetto all’anno precedente.

IA e relazioni

Le tecnologie digitali sono arrivate a permeare ogni ambito della vita quotidiana e a ridefinire i processi di relazione tra gli esseri umani. Un recente studio della University of Pennsylvania mostra che utenti di chatbot (assistenti virtuali) possono sviluppare forme di attaccamento simili a quelle umane: gli utenti possono arrivare a descrivere i bot come “amici”, “partner”. A tal proposito, si parla di “AI companion” quando si ha a che fare con sistemi conversazionali avanzati, progettati per offrire compagnia, conversazione e supporto emotivo, simulando dunque relazioni umane. Negli Stati Uniti tale fenomeno sta registrando una crescita grazie a delle piattaforme specializzate dove gli utenti non si limitano a richieste più o meno specifiche al chatbot, ma conversano con loro, simulando relazioni intime. Si tratta di una tecnologia sviluppata per instaurare legami affettivi, facendo leva su accettazione incondizionata, accondiscendenza, presenza costante e assenza di giudizio, tutti elementi che li rendono più rassicuranti e accessibili rispetto a molte relazioni reali. Gli utenti sono spinti a credere che questa tecnologia abbia una personalità autonoma e di avere un rapporto concreto che, soprattutto per persone vulnerabili, può rappresentare una scappatoia alla solitudine, con il rischio di non considerare i pericoli derivanti.

IA e impatto emotivo

Uno studio preliminare condotto dall’Istituto Superiore di Sanità (ISS) in collaborazione con l’Ordine degli Psicologi del Lazio evidenzia che circa il 7% degli under 30 dichiara di “affidarsi spesso all’IA per parlare dei propri problemi personali” e che 1 su 4 non distingue del tutto le competenze tra un assistente digitale e uno psicologo umano. Le persone possono affezionarsi all’IA come ad un amico o partner sviluppando legami emotivi sostitutivi delle relazioni umane e arrivando anche ad isolarsi socialmente. Alcuni centri di salute mentale segnalano una nuova forma di dipendenza relazionale da intelligenza artificiale, che si manifesta con irritabilità, ansia e senso di vuoto quando il contatto viene interrotto.

Quali possono essere le forme di tutela degli utenti?

Serve un’educazione al dialogo digitale e non lasciare le persone sole davanti a strumenti che imitano la relazione umana, ma non ne condividono i limiti etici.

In risposta alle crescenti preoccupazioni, anche OpenAI ha invitato pubblicamente gli utenti a non utilizzare ChatGPT come supporto emotivo o psicologico. “Non è uno strumento affidabile per la salute mentale,” ha dichiarato il CEO Sam Altman.

Come accade spesso quando si parla di intelligenza artificiale, la questione è ancora in divenire e, ad oggi, non esistono leggi o norme comportamentali su buona parte delle implicazioni pratiche che riguardano l’utilizzo di questo strumento.

Puoi avere altre informazioni contattando lo sportello S-collegati al 353 4204911.

Servizio Dipendenze Treviso “La Madonnina”, 3° piano

Via Castellana 2 – Treviso

Servizio Dipendenze Distretto di Oderzo Via D. Manin 46